tg-me.com/knowledge_accumulator/136

Last Update:

GAIA: a benchmark for General AI Assistants [2023] - достойное испытание или очередной тест на запоминание?

Авторы приводят следующую проблему появляющихся бенчмарков - их делают всё более и более трудными, добиваясь этого засчёт углубления необходимых знаний для ответа на вопрос, например, знание узкоспециализированного научного факта.

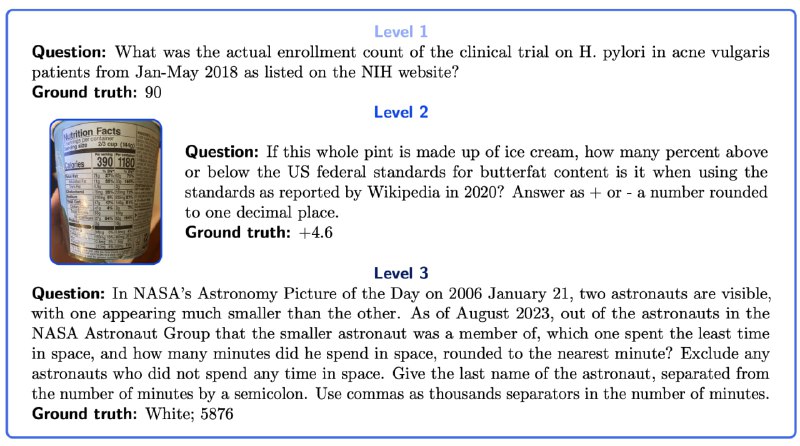

Но на самом деле рядовые задачи человека - это выполнения длинных цепочек простых операций, связанных с анализом содержимого файла, поиска в интернете, считывание чего-то с сайта и т.д. Именно такого рода испытание для моделей подготовили авторы данной работы. Они вручную составили 466 таких вопросов трёх уровней сложности (см. картинку).

Человек решает 90% вопросов, тогда как GPT-4 с настроенными вручную плагинами набирает только 30% на первом уровне сложности. На третьем уровне сложности та же модель показывает нулевой результат.

На мой взгляд, бенчмарк интересный. С одной стороны, он не проверяет интеллект, как обучаемость, то есть успешное прохождение не гарантирует нам тот самый AGI. Но это отличный тест на применимость AI в реальной жизни в качестве ассистента. Однако, и тут есть одно но.

Это всё будет иметь смысл только в случае, если GAIA будет black-box бенчмарком!

Если вопросы тестовой части бенчмарка выложат в интернет, это неизбежно приведёт к тому, что, во-первых, это попадёт в претрейн вместе с ответами, которые любезно оставят где-то в комментариях, а, во-вторых, разработчики неявно начнут зашивать в модель bias в сторону ответов на конкретные вопросы из GAIA.

Закрытость тестового входа стала ключом качества ARC, как теста на обучаемость, не позволившим исследователям неявно решить задачу "вместо модели" и таким образом обойдя сложность. Будем надеяться, авторы GAIA обеспечат честное и сложное соревнование.

@knowledge_accumulator

BY Knowledge Accumulator

Share with your friend now:

tg-me.com/knowledge_accumulator/136